WIN运行LLAMA模型教程(附模型下载链接)

需求:CPU

内存最好大点

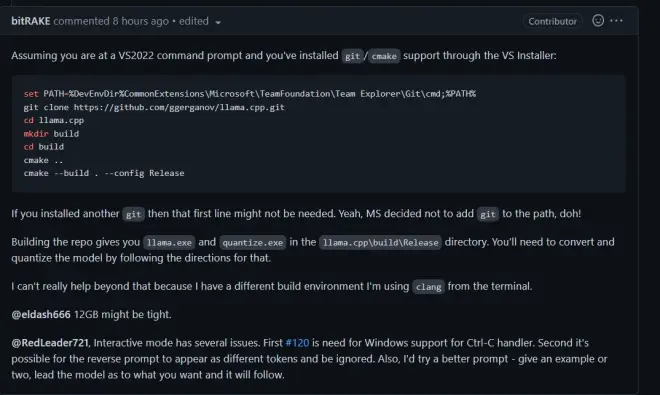

参照这个项目https://github.com/ggerganov/llama.cpp/issues/22

直接按照https://github.com/ggerganov/llama.cpp/issues/22

*这个ISSUE最后也是我写的,只不过搬运到B站来。

这位大佬的方法编译,记得用

这个东西把cmake装上去。

然后愉快的编译开始了,等待即可。

接着我们会发现得到三个文件

后面两个EXE是需要用到的。

然后我们来转化模型(链接:https://pan.baidu.com/s/1Y7YWdFWX1Yzy2Yuujp8Tqg?pwd=1p5n

提取码:1p5n

--来自百度网盘超级会员V4的分享

)

直接写原模型的绝对路径(在实操过程中很多时候会被路径坑死)

然后等待

完成后利用之前编译好的quantize.exe进一步转换

等待完成。

然后看你心情把llama.exe加入环境变量还是直接拖过来操作,参数都有给出,照着来即可。(记得把GBK改成UTF,该死的编码问题。)

玩得开心。