Novel AI 更加懒狗,AutoDL安装

先看评论区置顶和镜像readme,确定有无改动!!!

镜像readme:https://www.codewithgpu.com/i/AUTOMATIC1111/stable-diffusion-webui/SDwebui-LazyDog

如果镜像在AutoDL算力市场搜索不到或者readme网址打不开,说明我更新了镜像正在审核,请等一段时间,等不及的可以私信我分享镜像。

原教程还是不够懒狗,而且有很多问题,搞了个更加懒狗的。

新的更加懒狗教程理论上来说只适合AutoDL。

所有在本页面复制的命令,记得删掉B站自动在后面添加的版权声明。

1 租借并开启服务器

1.1 注册 AutoDL

声明:我不是在为 AutoDL 打广告,只是因为它支持对接网盘直接传输,并且比较便宜。如果有能力的可以自己寻找其他 GPU 服务器提供商。

https://www.autodl.com/login

如果你用我的邀请链接注册 https://www.autodl.com/register?code=470980a4-c4f5-40b3-9972-f49f163930b6 ,你充满100我会有30代金券。如果你是慷慨的石油佬,请(

注册 AutoDL 账号,推荐绑定微信。如果是学生建议通过学生认证,有优惠。

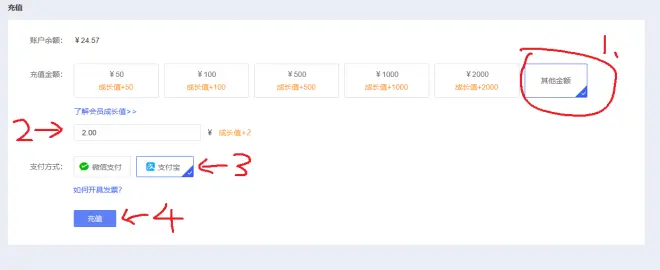

然后点击右上角充值界面:

充个2块钱(石油佬可以充多点),支付方式无所谓,好像现在新用户注册有10元代金券,那就可以先不充钱直接白嫖。以后注意钱不够记得充,不然没钱了会直接断电

1.2 创建服务器

点击左上角的市场

选择区域,选择GPU。注意选择显存最好大于16G(3080 如果生成的图的分辨率太大有可能爆显存),数据盘50G的。一个区域没有你想要的GPU可以去别的区看看。

推荐 3080/3080ti,富哥可以 RTX 3090或A5000。具体选什么卡合算,可以看我的评测文章。

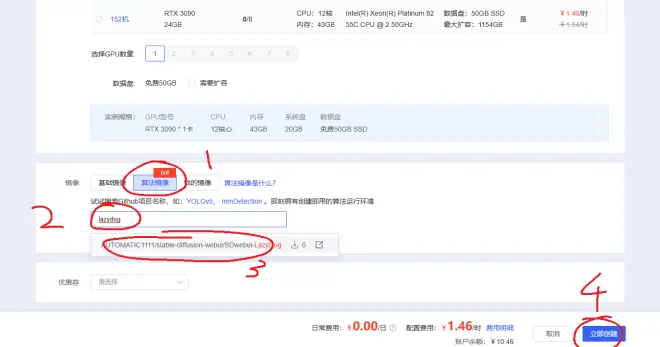

搜索并选择 lazydog 镜像并创建

稍等一段时间就创建好服务器了。先点击关机(只是为了教会你这个操作)。以后不用了都可以到这里直接关机。(不要在意我前后图服务器不一样,我懒得截新的图,复制原来懒狗教程的)

现在开机,稍等一会会显示“运行中”。

1.3 登录服务器

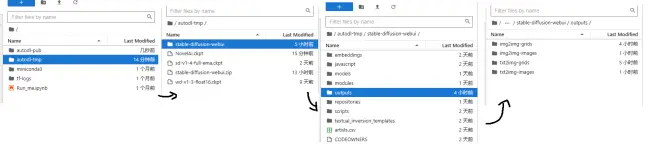

点击图中的jupyterlab,会弹出来一个新的标签页

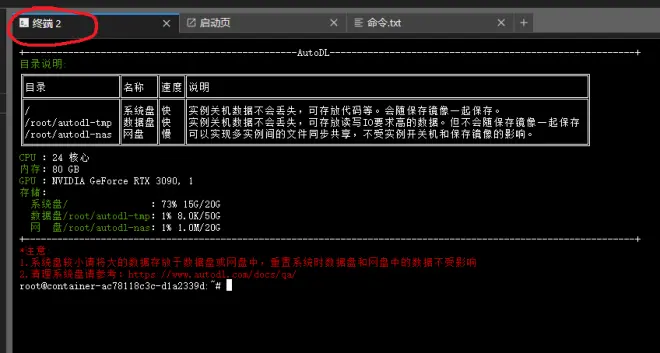

新标签页界面如下图:

2 部署

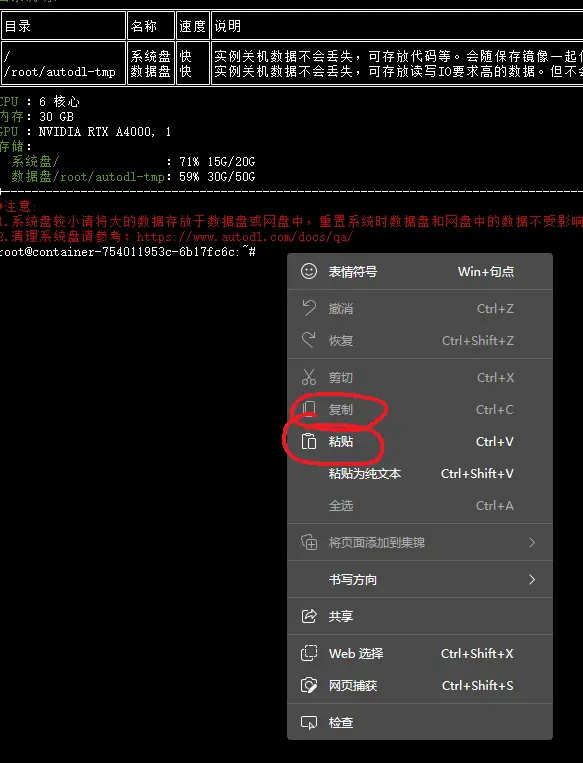

在 JupyterLab 终端里,按住shift并鼠标右键可以复制粘贴。不要用 Ctrl+C(强制关闭进程)。

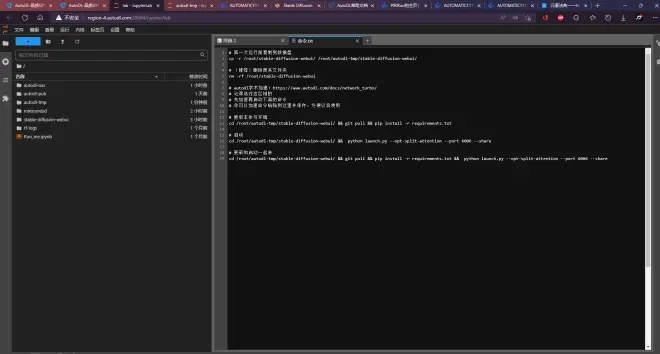

主要命令都在stable-diffusion-webui/先打开看我.txt里,可以从这个文件复制命令。

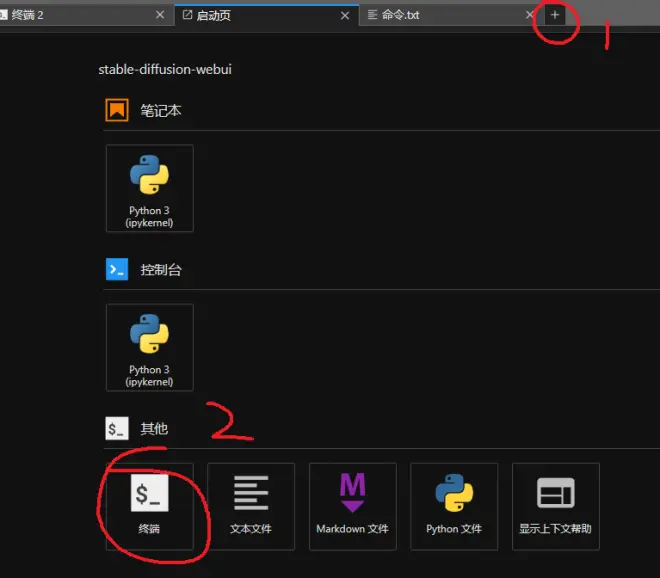

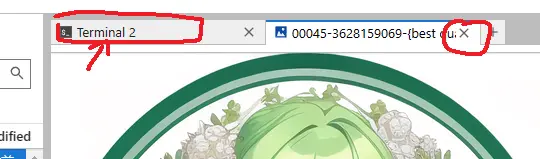

点击终端2

或者新开一个

2.1 安装更新与依赖

webui作者更新很频繁,所以即使安装好了,建议隔几天更新一下。

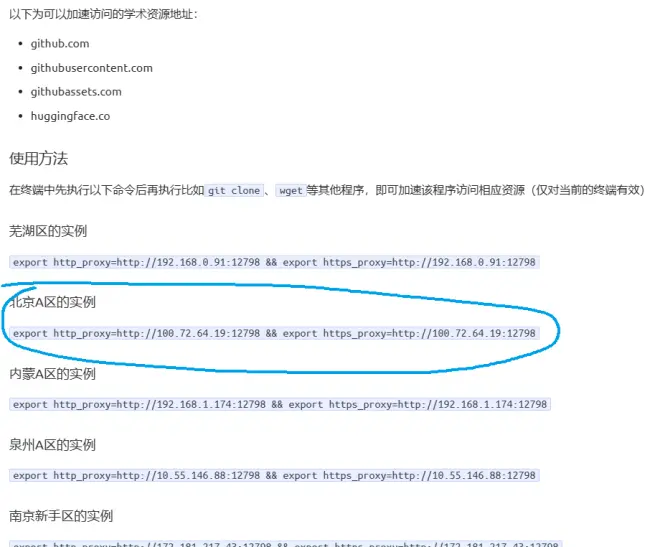

然后按照 https://www.autodl.com/docs/network_turbo/ 的教程,按照自己服务器的区域输入对应加速命令。比如我是北京区的,我就输入:

然后更新和安装依赖:

2.2 开始运行!

输入并回车

如果启动失败,把服务器关了重新开机,再试一次 2.2。

2.3 (强烈推荐)修改图片的保存地址

因为现在玩的人很多,关机了卡很容易没了,需要频繁换机。把图片的保存地址改到网盘方便换机后使用。

首先,记住你的区域,申请对应区域的网盘(有些大区没有网盘功能)

申请成功后,

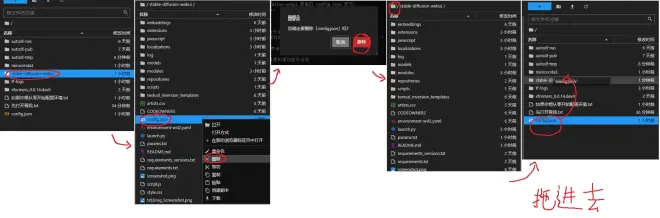

方案A 如果你之前没改过设置或者你是懒狗

可以直接按照下图的步骤,删掉原来的设置文件,把我准备好的拖进去;

方案B 如果你改过设置或者你想自定义文件夹

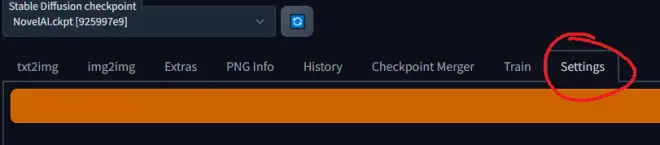

按照2.2启动后,进入webui网页-settings

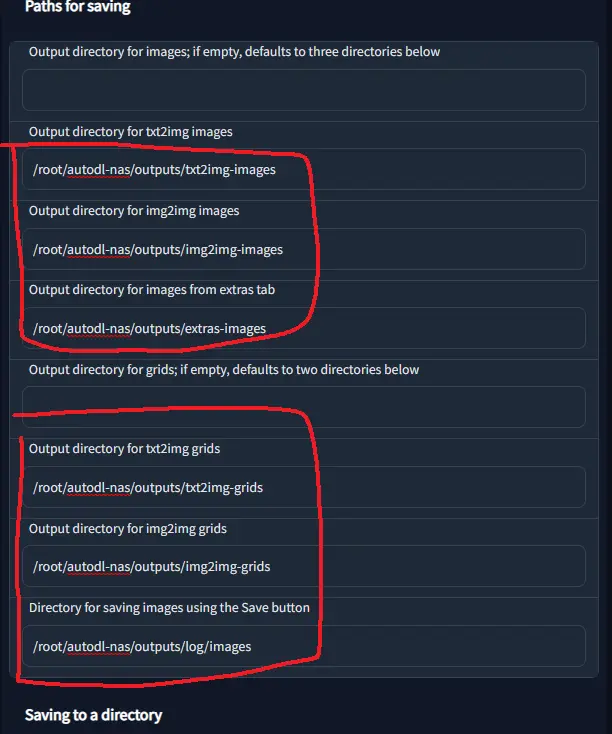

拉到下面,更改保存路径为如图

加前缀:/root/autodl-nas/,或者你也可以自己设置

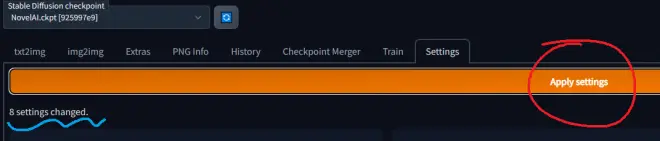

别忘了拉到上面apply

2.4 获取生成的图

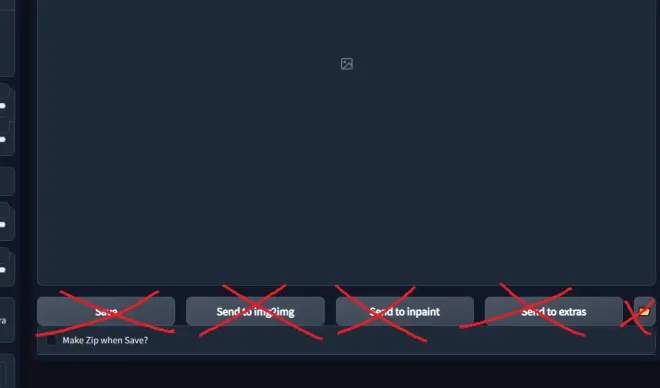

因为是在远程跑,所以网页的保存是没有作用的。

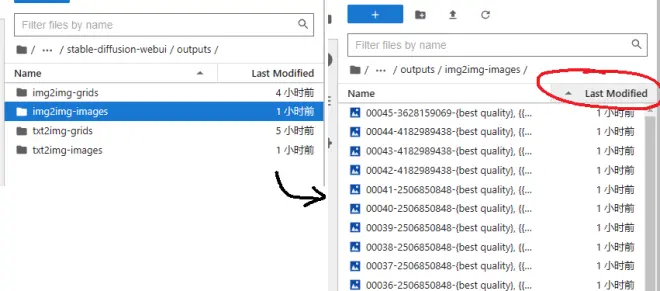

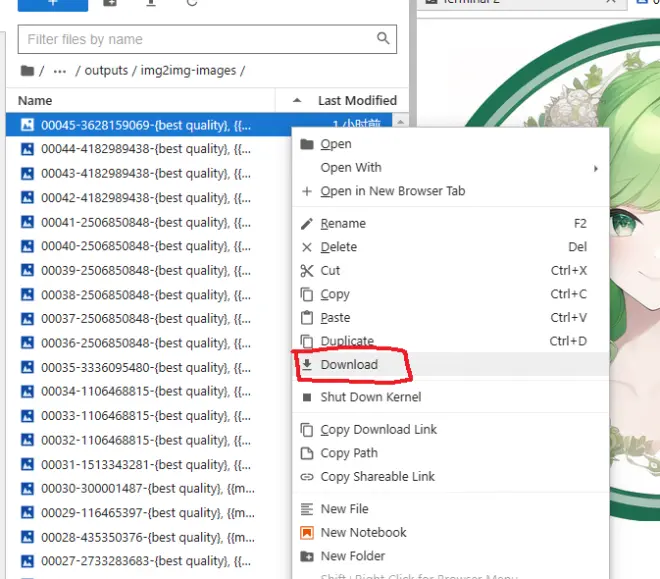

按照图里的步骤双击文件夹到输出路径下(如果你如2.3改了保存路径或者走的是A路线,要自行变通定位到输出文件夹)

比如我们现在要以图生成图的结果,就进img2img-images文件夹,然后点击Last Modified变成时间倒序

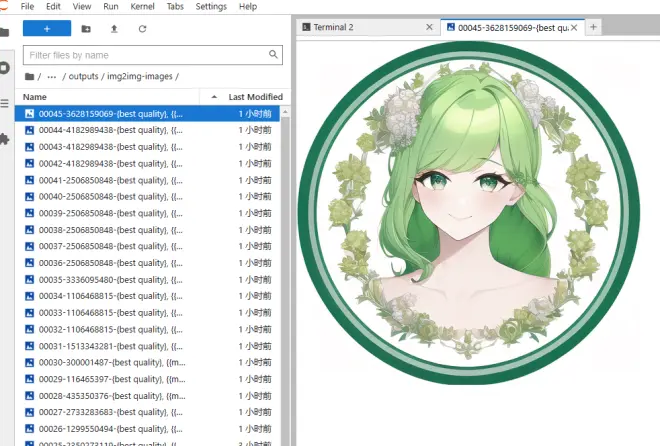

可以双击文件名,预览图片

标签页可以关闭,也可以随时回到终端

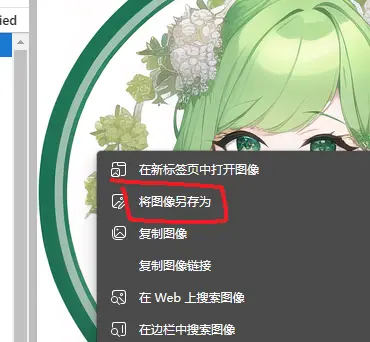

要下载带本地,可以:

在左侧右键选择download

或者可以在图片右键另存为

3 进阶

3.1 启用XFORMERS

Xformers可以大幅加速生成和减少显存占用,具体测试见我的评测文章。要启用它,只需要启动时在后面加上启动参数 --xformers:

!!!第一次使用XFORMERS前注意!!!

因为AutoDL的容器特性限制,在AutoDL的Linux服务器上无法用常规方式安装 XFORMERS ,需要自行编译。 不同核心代号的显卡需要不同的编译包,不能混用。

当然,这是懒狗包,我已经帮你解决了(大部分)。

如果你的服务器用的是 sm86 核心的显卡(3080,3080TI,3090,A40,A4000,A5000。理论上3070 3060也行,但是我抢不到显卡没测试过),你无需任何操作,已经安装了对应的 XFORMERS。

但是如果你不是,则在第一次启动前,按照你的显卡核心代号输入对应的命令,卸载针对 sm86 核心的包,安装正确的包。

卸载时会提示 Proceed (Y/n)?,输入y并回车确认即可。

sm80(A100所有版本)

sm75(2080TI)

sm70(V100所有版本)

sm86(如果你是sm86的显卡但是自己手贱装错了)

如果你的显卡不在上面,很抱歉,建议你换卡。

自行编译的教程(小白不推荐):https://github.com/facebookresearch/xformers/issues/473

3.2 启用DeepDanbooru

之前linux上用DeepDanbooru会报错,但是最近作者修复了这个问题。

DeepDanbooru主要是用于训练。当然,你也可以丢一张图给它然后推测可能的tag。

要启用它,只需要启动时在后面加上启动参数 --deepdanbooru:

当然,你可以和Xformers组合,一起加到后面:

3.3 把webui移到数据盘

如果你认为你有生成大量图片、训练、用更大更多的模型的需求,因为原系统盘空间不够,需要把webui文件夹移动到数据盘。

输入并回车以下命令,把文件夹移动到数据盘

移动之后,更新命令变成

启动命令变成

3.4 训练

本懒狗包用的是清除了EMA权重的pruned版(4G)ckpt,训练最好使用完整的latest版(7G)。因为大部分懒狗不会有训练的需求,因此如何替换模型ckpt文件和vae文件请自行摸索(你都训练了不会不知道换什么吧)。

4 服务器转移数据

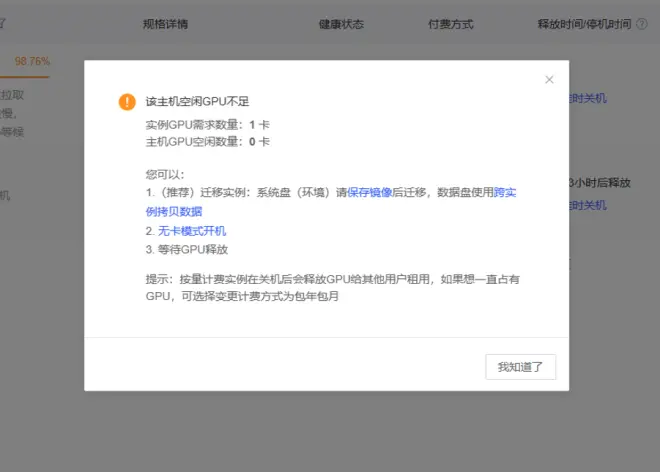

有时候你前一天晚上玩完关掉服务器睡觉,第二天发现没卡了

不要慌,更不用从头来过一次。只需要转移服务器数据即可。

当然,单纯只是想换服务器也是可以的。

(如果你不急,也可以等到有多的GPU空出来,但是鬼知道等到什么时候)

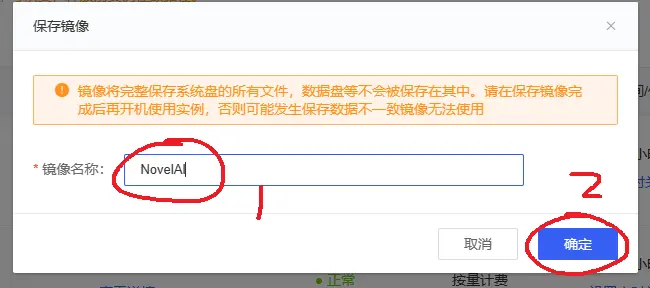

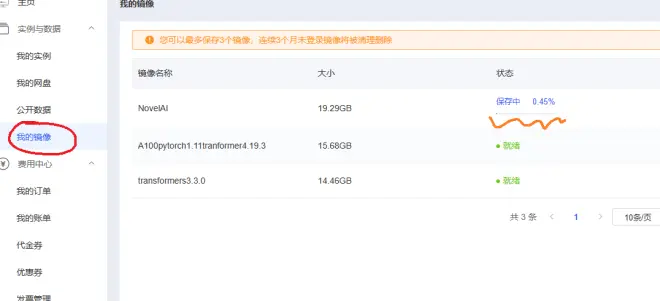

4.1 保存镜像

先确保服务器已关机,然后选择保存镜像

命名为 NovelAI,保存

点击“我的镜像”,耐心等到完成(约10分钟)

4.2 选购新服务器

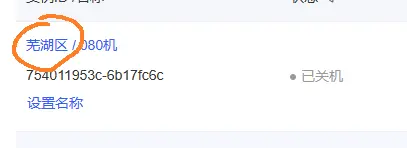

记住你原来的服务器是什么区的

然后按照 1.2 选一台新服务器。注意:要同一个区域,不过GPU型号可以不同,镜像选择我的镜像

选择刚刚创建的NovelAI镜像,然后确定,等待一段时间直到创建完毕并开机。之后不要关机,保持开机状态。

4.3 拷贝数据盘(如果没有3.3移动文件夹,不需要这一步)

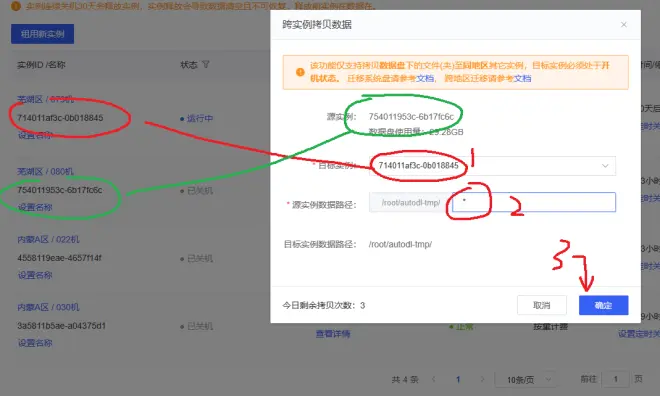

然后在之前的服务器选择跨实例拷贝数据

目标实例选择新开的服务器,路径填*,然后确定

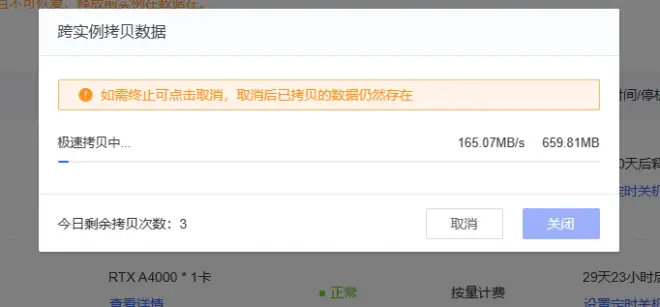

等待完成

完成后,就可以在新机登录并开启了。