深入理解位深、码率和RAW

深入理解位深、码率和RAW

前言:

在拍摄和导出时,你又经常看到8bit、10bit以及100M、200M这些数字,他们分别代表了位深和码率。

那么这些概念从何而来,对实际创作又会产生什么影响?

本期从位深的角度去剖析码率和RAW格式。

位深:

在描述图像时也称为颜色深度,

我们用色深来表示每个颜色分量所能呈现的变化数量。

位是比特,是二进制计算机中最小的单位,

每一个比特都只存在两种状态,用0和1来表示。

这样如果有8个bit,就能表示256种不同的状态。

对一个8bit色成的像素来说,RGB每个通道的颜色都可以呈现出256种变化,3个通道在一起就可呈现出超过1670万种变化。

同理,对于10bit色深的视频,这超过10亿种颜色变化,

12bit则超过了687亿种。

关于色深有两点需要注意:

第1:要注意区分色深的具体含义。

在过去,色深会用来表示所有颜色分量的总比特数,比如在过去说的8位色深时,拢共只有256种颜色变化。

第2:不要和色域的概念混淆

色域表示的是颜色的范围有多广,色深表示的是记录或者呈现颜色的精度有多高。

视频码率:

指的是单位时间内视频的数据量或者说位数,所以叫比特率。

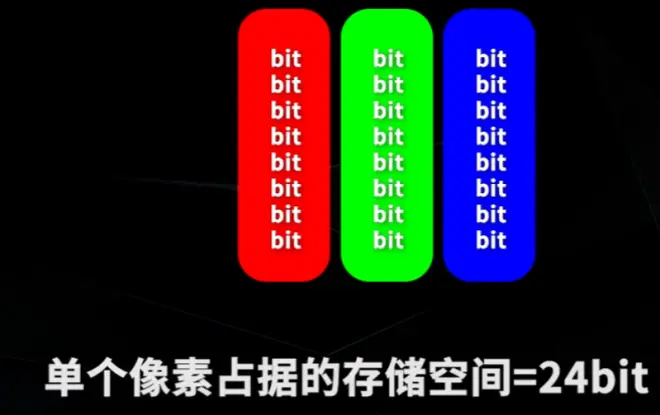

对于8位测试的RGB视频来说,每个像素都有3个颜色,分量就占据24位。

我们知道位和字节存在着8倍的关系,所以每一个像素要占据3个字节。

对于分辨率是1080P的视频来说,一共有2073600个像素,要存储1帧画面就需要6220800个字节,换算成千字节是6075KB,再换算成M,字节是5.93M。

我们知道视频是由一帧一帧的静态画面组成的,如果每秒有25帧,就需要大约148M的空间。

作为一个惯例,

描述存储空间时用字节为单位

描述传输数率时用比特为单位,是148,再乘以8,大约是1186M比特每秒。

我们可以用达芬奇找出一段这样的视频,选择编码格式为无压缩,

就能轻松验证这个结果。

而实际的情况是,一般的拍摄都难以负担这么高的码率,所以会使用不同的编码对视频进行压缩。

比如索尼的XAVC S-I 4K格式,

它能以10比特色深精度记住影像,如果不做压缩,当帧速率为50时,码率会超过1万M比特每秒,

但是配合422的色度采样和帧内压缩,码率可以下降到600M比特每秒

而XAVC S-I 4K格式还使用了帧间压缩,码率可以进一步下降到200M比特每秒。

进而如果使用XAVC HS 4K的格式,它采用H265的编码,码率能再次下降到100M比特每秒。

较低的码率节省了所需的存储空间,而代价要么是牺牲了画面的质量,或是在解码时需要更多的算力和软硬件的编解码支持。

对于调色来说,相同编码的素材,色深和码率越高越好,

码率越高画质越高,像色带这类情况出现的概率也就越低。而后期能拿到的质量最好的素材格式就是RAW.

RAW格式:

是未经处理的原始图像格式,色深通常可以达到12bit、16bit或者更高。

但是当我们用上面的方法去计算RAW素材的码率时,会出现问题。

比如这段素材,这是摄影机拍摄的12比特色深视频,

这是一种未经压缩的格式,所以我们套用之前的计算结果是每帧画面大约要占据35.6M的空间,而实际情况是中的素材有277帧,大小为3.21GB,算下来与知画面只有11.9兆.

差不多,只计算值的1/3。

再换一条视频计算结果同样如此。那为什么RAW素材占据的存储空间只有理论值的1/3呢?

就要回溯到绕素材诞生的地方,感光元件。

感光元件:

是由几百万个微小的感光点组成的阵列,

每个感光点上都有一个微透镜,进一步汇聚光线,

它的本质是一个光子计数器,计算单位时间内进入的光子数量,并将你转换为数字信号。

色深越高就意味着每个感光点记住光子的精度越高。

这里需要注意的是,感光点并非和最终得到的像素点是一一对应的关系。

比如感光点的阵列是2880x1620,

在拍摄1080P的视频时画面会经过3 : 2的下采样,同样也可以做3 : 4的上采样,

也能得到被认可的4K分辨率。

感光点只能记录光子,并不能记录光子的频率,他并不知道光的颜色是怎样的,他只能记录灰度图像。

为了能记录彩色图像,改成了三传感镜摄影机,他用棱镜和二相色镜把入射的光线分成了红、绿、蓝三色光。

而如今的摄影机只会用一块感光元件同时处理三元色。

那要怎么做?

给每个感光点加一个不同颜色的滤镜,

它只允许特定颜色的光线通过。这种像马赛克一样的彩色滤镜阵列被称为拜耳滤镜,

滤镜上有一半颜色被绿色占据,红色和蓝色各占1/4。

看过上期视频的朋友应该知道,这样做是因为我们眼睛对绿色最敏感,所以权重更高。

上期视频深入 422 420 的底层逻辑:https://www.bilibili.com/video/BV1oP4y1m7Nm/?vd_source=aa83aa39c00723051d92545917f8cf3b

感光元件上直接得到的画面是这样一个马赛克的图像,

每个反光点只记录某一个颜色通道的数据,若要还原现实场景的本来面目,就成为去马赛克,或者叫去拜尔,解拜尔

解拜耳的方法相当复杂,具体的算法都是各个制造商严格守护的机密。

大致的思路都是从心里的感光点做彩色插值的计算,比如某个感光点的数据是绿色,那么它丢失的红色和蓝色信息就可以从相邻的像素中推断出来。

常见的视频解拜耳的过程都是发生了相机内部

解拜耳后得到RGB的画面,然后对RGP画面进行编码压缩,就得到了一个个视频文件

作为对比RAW格式将马赛克的原始图像直接编码,解拜耳的工作则放到了回放或者后期的环节。

所以在RAW格式中,每个像素点只记录一个颜色通道的数据,而非3个,所以在计算码率的时候,未经压缩的RAW格式不需要再乘以3.

.r3d , RedCode RAW格式,一般会在RAW的基础上压缩到三分之一甚至更低,对于这种RAW的码率就不能直接算了。

Arri的码率计算器:https://tools.arri.com/fileadmin/adapps/afdc/index.html

Red 码率计算器:https://www.red.com/recording-time

RAW格式凭借着拜耳滤镜和之后的解拜耳算法在事实上将数据压缩到了1/3。

上面的计算时,其实每个RAW素材占据的空间和我们的计算都差了一点几M,因为ArriRAW的元数据和视频数据是分开存储的。

像ISO、白平衡等等数据如此存放的元数据里面,并没有烧入到视频中,这在后期可以修改元数据的各种参数。

所以解拜耳尽管会消耗更多的计算资源,但是给后期提供了极高的自由度。

总结:

介绍了色深的概念,它用来表示记录或者显示颜色的精度。

介绍了无压缩视频的码率计算

最后我们简单介绍了RAW格式的视频,可几分钟的时间只说了他的冰山一角,以后有机会再做分享。

------笔记结束------