深度学习-图像篇-神经网络常用激活函数

1. 人工智能的目标:

a) 让机器人和人一样思考:机器学习

b) 让机器人和人一样听懂:语音识别

c) 让机器人和人一样看懂:视觉识别

d) 让机器人和人一样运动:运动控制

2. 人工智能、机器学习、深度学习的关系:

机器学习是实现人工智能的一种途径,

深度学习是机器学习的一个子集。

传统机器学习和深度学习的区别:

传统机器学习算术依赖⼈⼯设计特征,并进⾏特征提取,

深度学习⽅法不需要⼈⼯,依赖算法⾃动提取特征。

3. 机器视觉任务进行目标拆分:

a) 理解图⽚中的场景(办公室,客厅,咖啡厅等)

b) 识别场景中包含的物体(宠物,交通⼯具,⼈等)

c) 定位物体在图像中的位置(物体的⼤⼩,边界等)

d) 理解物体之间的关系或⾏为(是在对话,⽐赛或吵架等)

e) 理解图像表达的意义(喜庆的,悲伤的等)

分为三⼤经典任务:图像分类、⽬标检测、图像分割

图像分类(Classification)将图像结构化为某一类别(category)的信息

⽬标检测(Detection):检测则关注特定的物体⽬标,要求同时获得这⼀⽬标的类别信息和位置信息(classification + localization)。

图像分割(Segmentation):对图像的像素级描述,它赋予每个像素类别(实例)意义

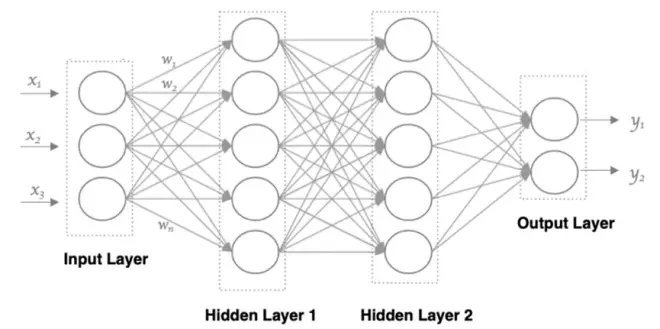

4. 神经网络:

⼈⼯神经⽹络( Artificial Neural Network, 简写为ANN)也简称为神经⽹络(NN)

人工神经元(神经网络组成结构):

x:输入特征矩阵

w:特征权重

b:偏置参数

f:激活函数(activation function)

神经网络

神经网络特点:

同⼀层的神经元之间没有连接。

第N层的每个神经元和第N-1层的所有神经元相连(这就是full connected的含义),第N-1层神经元的输出就是第N层神经元的输 ⼊。

每个连接都有⼀个权值。

5. 激活函数

激活函数本质:向神经⽹络中引⼊⾮线性因素

非线性激活函数的优点:如果不⽤激活函数, 每⼀层输出都是上层输⼊的线性函数,⽆论神经⽹络有多少层,输出都是输⼊的线性组合。而引⼊⾮线性函数作为激活函数,那输出不再是输⼊的线性组合,可以逼近任意函数。

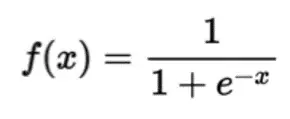

6. 常见激活函数--- Sigmoid/logistics(同名)

数学表达式:

表达式图像:

优点:

sigmoid 在定义域内处处可导

缺点:

梯度消失:如果X的值很⼤ 或者很⼩的时候,那么函数的梯度(函数的斜率)会⾮常⼩,在反向传播 的过程中,导致了向低层传递的梯度也变得⾮常⼩。(一般5层会出现梯度消失问题)

激活函数并不是以0为中⼼的

总结:

sigmoid函数⼀般只⽤于⼆分类的输出层

tensorflow实现:

y = tf.nn.sigmoid(x)

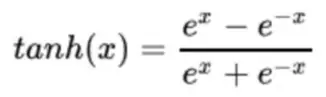

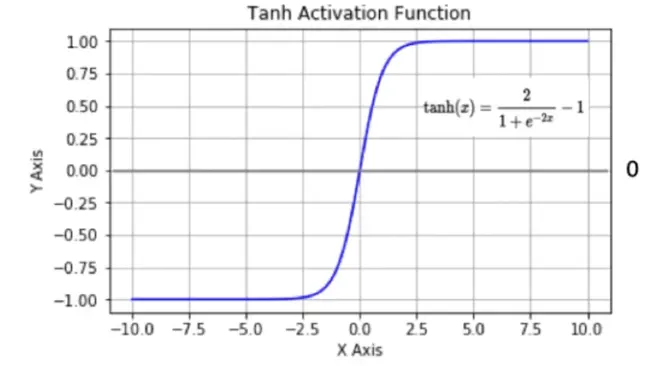

7. 常见激活函数---tanh(双曲正切曲线)

数学表达式:

表达式图像:

优点:

激活函数是以0为中⼼的,值域较大,斜率较大,收敛速度要⽐sigmoid快,减少迭代次数。

缺点:

依然存在梯度消问题:通过归一化,当输入∈[-1, 1] 时可以解决梯度消失问题

总结:

tanh函数常在隐藏层使⽤

tensorflow实现:

y = tf.nn.tanh(x)

b站的富文本编辑器太难用了,先写到这里。 后边研究一下怎么用markdown方便一些