英伟达 GH200 登场,黄仁勋:AI 模型执行成本将大降

为抵御超微(AMD)、Google 及亚马逊(Amazon.com)在人工智能(AI)硬件领域的竞争,英伟达(Nvidia Corp.)新推了专门用来执行 AI 模型的全新芯片,并表示执行大型语言模型(LLMs)的成本将「显著降低」。

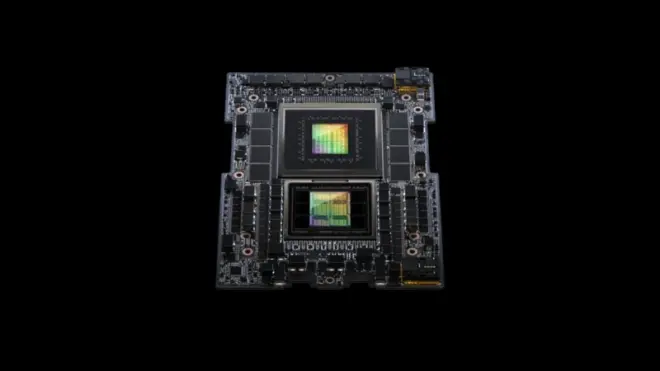

CNBC、MarketWatch等外电报导,英伟达执行长黄仁勋(Jensen Huang)8日在2023年绘图盛会「SIGGRAPH」(Special Interest Group on Computer Graphics and Interactive Techniques)发表次世代超级芯片「DGX GH200 Grace Hopper Superchip」,主要应用于大型内存生成式AI模型,例如OpenAI的AI聊天机器人「ChatGPT」。

GH200的Hopper绘图处理器(GPU)与英伟达目前最高阶AI芯片H100相同,但结合72核心的ARM架构Grace中央处理器(CPU),并搭配141 GB HBM3内存及每秒5 TB带宽。 另外,NVLink-dual GH200系统内置两颗GH200,可将容量扩充3.5倍、带宽增加三倍。

黄仁勋8日表示,这款升级过后的处理器专门应用于全世界最大数据中心的水平式扩充(scale-out)作业。

GH200预定2024年第二季上市,但英伟达并未说明定价。 黄仁勋仅指出,GH200可让大型语言模型的推论成本显著下降。

AI模型的工作过程可分为两部分:训练与推论(inference)。

首先,AI模型会以大量数据训练,过程可能花上数月,有时需要上千颗GPU,例如英伟达的H100及A100芯片。 之后,AI模型将被软件用来预测或产生内容,这个过程称做推论。 如同训练,推论过程相当昂贵,软件每次产生文字或内容都需要许多算力。 然而,AI模型只有在更新时才需要训练,推论却会持续不断发生。

英伟达副总裁Ian Buck 8日在电话会议表示,最新的GH200专为推论设计,因为这个程序需要更多内存容量,可让更大型的AI模型置入单一系统。

Buck指出,存储器容量加大,可让AI模型常驻单一GPU,执行时不再需要多个系统或多颗GPU来配合。

辉达8日股价终场下跌1.66%、收446.64美元;盘中一度在新产品发表后下挫最多3%。