python入门数据挖掘-数据爬取总结

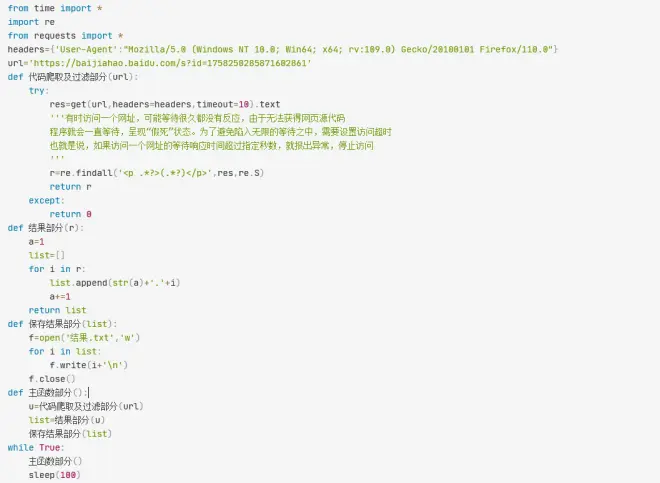

from time import *import refrom requests import *headers={'User-Agent':"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:109.0) Gecko/20100101 Firefox/110.0"}url='https://baijiahao.baidu.com/s?id=1758250285871602861'def 代码爬取及过滤部分(url): try: res=get(url,headers=headers,timeout=10).text '''有时访问一个网址,可能等待很久都没有反应,由于无法获得网页源代码 程序就会一直等待,呈现“假死”状态。为了避免陷入无限的等待之中,需要设置访问超时 也就是说,如果访问一个网址的等待响应时间超过指定秒数,就报出异常,停止访问 ''' r=re.findall('<p .*?>(.*?)</p>',res,re.S) return r except: return 0def 结果部分(r): a=1 list=[] for i in r: list.append(str(a)+'.'+i) a+=1 return listdef 保存结果部分(list): f=open('结果.txt','w') for i in list: f.write(i+'\n') f.close()def 主函数部分(): u=代码爬取及过滤部分(url) list=结果部分(u) 保存结果部分(list)while True: 主函数部分() sleep(100)