如何使用最小的存储空间跑完转录组数据分析(超500G的测序数据)

其实这一篇只是基于最近做转录组分析时的一个经验而总结出来的经验,相信大家看完都会有所体会(大佬应该想到过,所以除外,哈哈)。下面,话不多说,简单讲一下如何分析超多转录本样本(超500G的测序数据)时还能够有效的节省空间。

一小空间大计算的转录组分析方案

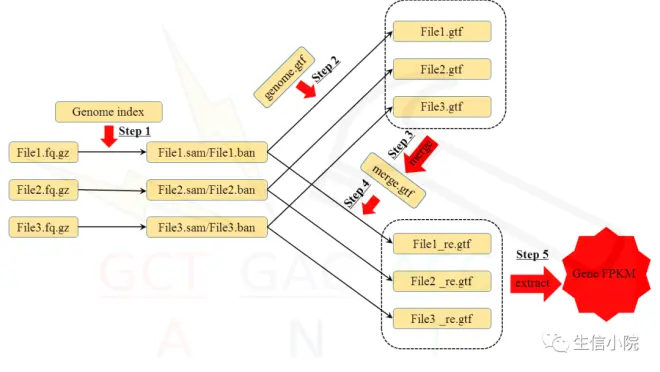

上图是一个常规分析流程:测序文件>比对结果>第一次定量结果>合并第一次定量结果>第二次定量结果>抽提并整合定量结果。但是,这一步骤中如果放任每个文件产生sam/bam文件,则会占用大量的存储空间。因此,当有计算资源而无存储空间空间时,大家可以像下面这样做。

其实很简单,就是将生成的sam和bam文件当做临时文件,每次调用前使用原始测序文件进行比对得出,并用于下一步的分析,这样就可以节省掉大量因为每个测序文件产生的sam和bam文件而占用的空间了。其实,其他类似的分析也可以采用这种方法,即将需要占用大量空间且可以被制作成临时文件的步骤采用本文的方法替代,虽然可能要花费较多的计算空间,但是这样在完成分析的同时能够节省必要的空间,也算是一种折中的解决方案吧。

三惯例小结

当然,希望大家都能够有无限量的计算空间和计算性能,这样就不用采取本文所提到的非常规的分析手段啦。最后,进一步推广一下我开发的相关软件,Multi-omics Hammer软件和Multi-omics Visual软件。这两个软件可以帮助用户快速实现数据分析,完成数据可视化工作,并且其中Multi-omics Visual是基于python开发的可视化工具,这也意味着其具有很广阔的扩展的空间。因此,如果后续用户有较好的反馈,本人也将继续维护。当然,如果大家使用了我的软件快速完成生信分析,可以考虑在发文章的时候添加相关引用(非常感谢啦)。如果读者觉得还有什么功能需要实现,也可直接通过公众号留言。

本公众号开发的相关软件,Multi-omics Hammer软件和Multi-omics Visual软件欢迎大家使用。文末是本公众号在其他平台的账户,也欢迎大家关注并多提意见。

简书:WJ的生信小院

公众号:生信小院

博客园:生信小院

最后,也欢迎各位大佬能够在本平台上:1传播和讲解自己发表的论文;2:发表对某一科研领域的看法;3:想要达成的合作或者相应的招聘信息;4:展示自己以寻找博后工作或者博士就读的机会;5:博导提供博后工作或者博士攻读机会,都可以后台给笔者留言。希望本平台在进行生信知识分享的同时,能够成为生信分析者的交流平台,能够实现相应的利益互补和双赢(不一定能实现,但是梦想总得是有的吧)。

另外,怎么说呢,投币也可,不强求,但奢求。