AI动画经验分享

最近有许多小伙伴询问,出一个专栏分享一下我制作AI动画的经验。

这并不一个完整的教程,主要是面对目前已经能够制作AI动画的同学,如果你对文章中的一些概念不理解,你可以先观看这位UP的一系列视频:大江户战士

废话不多说,直接上参数:

你就是我的天使 参数:

solo,1girl,symbol-shaped pupils,cross-shaped pupils,naxida64,<lora:nahidaGenshinImpact_1:0.8>

Negative prompt: (worst quality, low quality:1.4), (realistic, lip, nose, lipstick, eyeshadow:1.0), (greyscale, monochrome:1.0), text, title, logo, signature,easyNegative

Steps: 40, Sampler: DPM++ SDE Karras, CFG scale: 9, Seed: 3362304569, Size: 768x1536, Model hash: e4b17ce185, Denoising strength: 0.35, Clip skip: 2, ENSD: 31337, ControlNet-0 Enabled: True, ControlNet-0 Module: hed, ControlNet-0 Model: control_hed-fp16 [13fee50b], ControlNet-0 Weight: 0.5, ControlNet-0 Guidance Start: 0, ControlNet-0 Guidance End: 1, ControlNet-1 Enabled: True, ControlNet-1 Module: pidinet, ControlNet-1 Model: control_scribble-fp16 [c508311e], ControlNet-1 Weight: 1, ControlNet-1 Guidance Start: 0, ControlNet-1 Guidance End: 1, Eta: 0.68

视频帧率30,后通过软件补到60。

如果你没有ControlNet-pidinet,请把webUI更新到github最新版

爱你~ 参数:

solo,1girl,symbol-shaped pupils,cross-shaped pupils,naxida64,<lora:nahidaGenshinImpact_1:0.8>

Negative prompt: (worst quality, low quality:1.4), (realistic, lip, nose, lipstick, eyeshadow:1.0), (greyscale, monochrome:1.0), text, title, logo, signature,easyNegative

Steps: 30, Sampler: DPM++ SDE Karras, CFG scale: 9, Seed: 3362304569, Size: 768x1024, Model hash: 5493a0ec49, Denoising strength: 0.35, Clip skip: 2, ENSD: 31337, ControlNet-0 Enabled: True, ControlNet-0 Module: hed, ControlNet-0 Model: control_hed-fp16 [13fee50b], ControlNet-0 Weight: 0.6, ControlNet-0 Guidance Start: 0, ControlNet-0 Guidance End: 1, ControlNet-1 Enabled: True, ControlNet-1 Module: normal_map, ControlNet-1 Model: control_scribble-fp16 [c508311e], ControlNet-1 Weight: 0.6, ControlNet-1 Guidance Start: 0, ControlNet-1 Guidance End: 1, Eta: 0.68

视频帧率15,后通过软件补到30

主要就是LoRA,controlnet,还有 easyNegative 的embeddings,并没有什么黑科技。

使用参数的方法:

复制到prompt,然后点generate下面的那个箭头。

controlnet需要手动输入,参考我上面的数据。ControlNet-pidinet使用control_scribble 模型。由于是刚出的,我没找到它对应的模型。

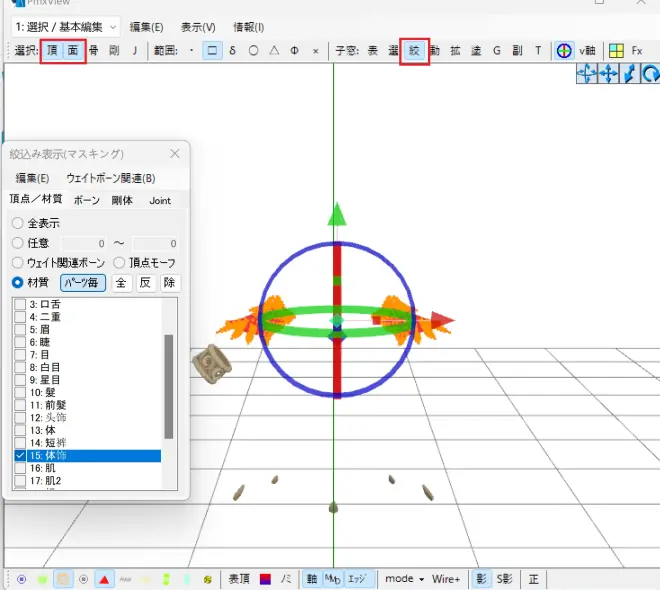

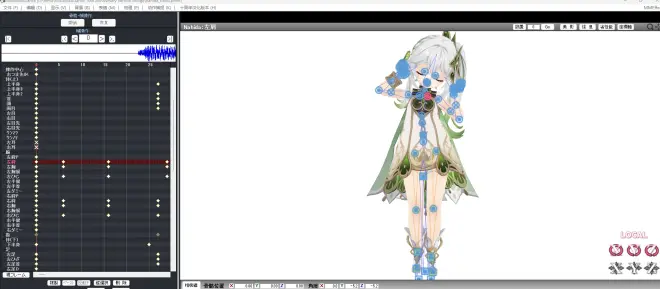

对于MMD模型的调整,使用PmxEditor 来编辑PMX模型:

删除小草神的臂甲,我感觉这个臂甲会影响AI对于胳膊的判断,经常画出怪异的胳膊。缺点是删了之后,AI有时候会尝试还原臂甲,在视频里面经常看到胳膊有臂环出现消失。

2. 修改手臂和头发的物理碰撞。很多人发现视频里面头发穿模了,这是故意的。这是为了避免手臂打到头发,导致头发乱飞,影响画面稳定。

对于镜头的调整:

为了让人物保持在画面中心,需要制作镜头动作。这是为了提高人物在画面中的占比,可以提高AI出图的质量。

如果你不熟悉K镜头,你可以使用MMD的相机的骨骼追踪:

不过这个镜头追踪其实看起来特别怪,可以测试的时候用。最终出视频应该是用不了,还是自己努努力K一个镜头吧。

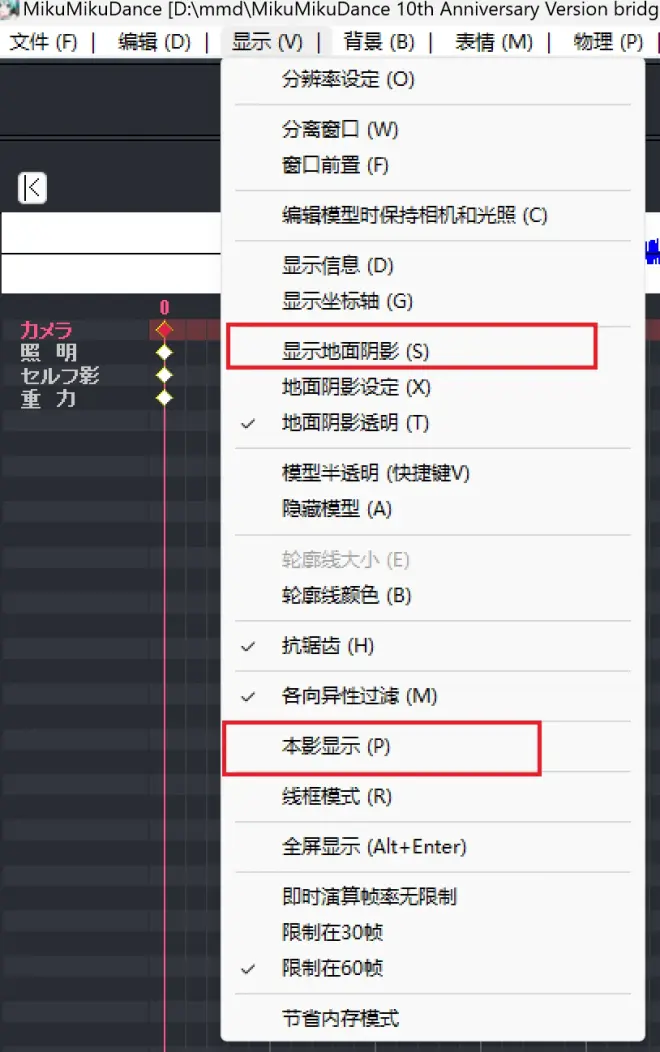

MMD的一些配置:

1. 取消本影和地面阴影,避免对AI造成影响,让AI给你上光影。

2. 修改动作。 有一些动作穿模了,还有些动作,人物面部被大面积遮住。都会影响AI出图质量。虽然可以通过降低重绘幅度解决,但最好还是调整原图。

在img2img过程中的一些经验:

1. 在人物侧身,背面,或者脸部被大面积遮住的情况下,AI出图质量很差,通过降低重绘幅度来避免。 我一般都会提前吧这些帧单独拉出来,调整参数处理。

2. 筛选出所有人物闭眼的图片,在img2img这些图片的过程中。prompt中的symbol-shaped pupils,cross-shaped pupils 替换为closed eyes。在人物闭眼的时候,提示词和实际画面有冲突,会导致AI出图质量变差。

总结:

大致就是上面这些内容了,并没有什么黑科技。都是通过不断的调整以及各种细节的累积,提高画面稳定性。

通过人物的LoRA和controlNet,基本可以控制人物服饰,饰品的稳定性。只有光影的变化会导致闪烁。这个可以通过降低帧率,降低重绘幅度,使用多帧渲染法来解决。

我尝试过使用0.5的重绘幅度,闪烁就很严重了。其实0.35也有点闪,不过我上传B站,B站给我二压之后闪烁现象减轻了很多,非常神奇。

我尝试过多帧渲染法,但最终没有使用。是由于它要耗费3倍算力。我的《你就是我的天使》,视频长度85秒,2600帧,4090 跑了20多个小时。如果上多帧渲染估计会超过80小时。后面我可能会尝试用高重绘幅度+多帧渲染,大江户战士好像就是这个组合。效果非常不错。