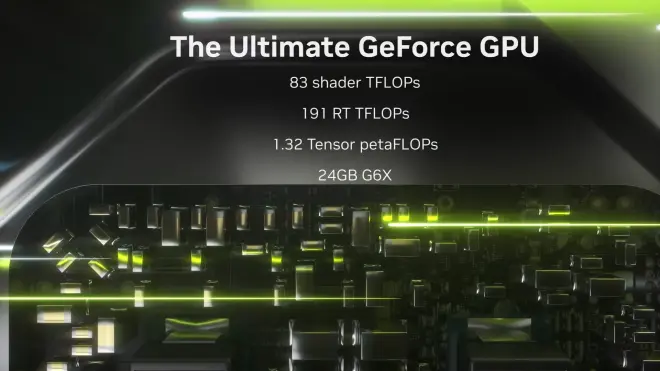

NVIDIA RTX GPU 性能单位的一些问题

0. Shader TFLOPs

这个放在第 0 号,其实就是 SIMD 的 FP32 浮点计算性能,等同于 FP32 TFLOPs. 没有任何问题。

1. RTX-OPS

NVIDIA 官方给出的解释是每秒钟的光线追踪操作(万亿次),稍微了解图形的人都知道这是非常笼统的说法,实际上这个算法还包括了用于处理深度神经网络的张量单元负载(DLSS)的权重。最重要的是该性能数据的计算方法也说得很含糊。(RTX-OPS 这个说法也只用在了图灵架构上)

与此同时 NV 开图灵架构显卡发布会的同时,还略微提到了一个人叫 GigaRays/sec 的衡量指标。实际上这个比什么 RTX-OPS 有价值多了,因为 10 GigaRays/s 可以直接认为是一般情况下每个像素进行 1 次采样的实时路径跟踪(目前所有主流光追游戏都是 1 spp 的标准),这样其实更形象化。

2. RT TFLOPs

这个概念就更抽象了,NV 直接不给你提包含了哪些数据,也找不到任何资料能得出该指标的衡量标准。个人认为是 RTX OPS 的翻版说法,然后略微更改各个子数据的权重。只不过"TFLOPs"这个常用于衡量计算机浮点性能的指标更被人熟知,听起来更熟悉而已。不过这个指标 NV 在发布 30 系之后对部分图灵卡进行了“单位转换”,用该指标对比对比 N 卡之间的光追性能水平还是可以的。但是该单位仍不具备普适性。

3. Tensor TFLOPs

相信了解过一点图灵或者安培卡的张量性能的人,最开始看到 4090 的这个所谓的 1.32 Tensor PFLOPs 是非常震撼的,因为 NV 的上一代旗舰 3090 Ti 也才 320 Tensor TFLOPs.

事实是,由于 Ada 架构使用了从 Hopper GPU 上扒拉下来的 FP8 Transformer 引擎,支持了 FP8 精度的数据运算。吞吐量比 FP16 高出一倍。

然而,NV 在不明面上告知任何人的情况下更改了 Tensor TFLOPs 的计算标准,从 Tensor FP16 改为了 FP8,并且用于衡量 40 系得显卡张量核心性能。

如果换成 FP16 格式的数据并且和 30 系对比,其实张量核心的性能提升没有从 320T 到 1320T 那么恐怖。

不过 NV 提供的 AI 算力数据还是比较值得普遍使用的,指明了衡量标准是什么。不仅仅是 FP16,还有苹果衡量他们家“神经引擎"性能标准的 INT8 格式数据指标也是提供在了架构文档里,可以直接比较。

最后也不得不感叹一句,NV 是会玩的。